Remote sensing image classification framework based on self-attention convolutional neural network

-

摘要:目的 遥感图像分类技术在森林资源调查、生态工程规划以及森林病虫害防控等林业监测业务中,扮演着至关重要的角色。通过引入自注意力模块增强卷积网络对遥感图像的特征刻画能力,以期提高遥感图像的分类效果。方法 该文提出了一种融合自注意力机制和残差卷积网络的遥感图像分类方法,首先利用卷积神经网络提取丰富的深度纹理语义特征,然后在卷积网络的最后3个瓶颈层嵌入多头自注意力模块,挖掘遥感图像复杂的全局结构信息。嵌入自注意力模块的卷积分类网络,能够有效提升遥感图像的分类精确度。该研究使用RSSCN7、EuroSAT与PatternNet 3个公开的遥感图像数据集,基于Pytorch深度学习库训练与测试该方法,并增加与已有分类框架算法精度和性能的对比试验。同时,使用不同批次、不同数量大小的数据训练改进研究提出的方法,并测试分类效果。结果 试验得出,该研究提出的方法在3个遥感分类数据集上的平均识别率分别达到了91.30%、97.88%和97.37%,其中在前两个数据集上较现有的基于深度卷积网络的算法分别提升了2.26%和3.73%。同时,该算法的总参数量为2.08 × 107,较现有参数量最低的方法减少了5.2 × 106。结论 相比已有的遥感图像分类框架,该研究提出的方法能够在图形处理器(GPU)加速的环境中,取得更为准确的分类效果。同时有效减少了模型的参数量,提高了算法执行的效率,便于后续的实际应用部署。Abstract:Objective Remote sensing image classification technology plays a vital role in forestry monitoring operations such as forest resource survey, ecological engineering planning and forest pest and disease control.Method The work proposes a remote sensing image classification method based on multi-headed self-attentive modules, which uses the convolutional neural network framework ResNet50 as the backbone network of the whole framework. The intermediate layers of the last three bottleneck layers of the ResNet50 network were replaced with multi-headed self-attentive modules, which enable the model to focus on the regions with the highest discrimination and thus improve the classification accuracy. The experiments in this study used three publicly available datasets, RSSCN7, EuroSAT and PatternNet, based on the Pytorch machine learning library, to train and test the framework, and add a comparison experiment with the accuracy of existing classification frameworks. At the same time, different batch sizes were used to train the proposed framework and test the classification effect.Result Experimental results showed the average recognition rate of the proposed method on the three remote sensing classification datasets reaching 91.30%, 97.88% and 97.37%, respectively, which was better than the existing algorithms based on deep convolutional networks. Also, the total number of parameters of this algorithm was 2.08 × 107, which was also much lower than that of existing algorithms.Conclusion The results show that the proposed framework is able to achieve higher accuracy in a GPU-accelerated environment, reduce the number of parameters included in the framework, reduce the video memory consumption, and improve the accuracy of the classification results compared with existing remote sensing image classification frameworks.

-

在实际生产生活中,遥感图像被应用于城市规划、森林状态评估、生态环境监测等诸多领域,并扮演着至关重要的作用[1]。这些应用的主要目的是通过对采集到的遥感图像特征进行提取和分析,准确判断出图像中所包含的主要目标类别,如建筑、森林或湿地等[2]。目前,实现遥感图像分类的有效手段主要是利用计算机技术模拟生物对视觉的感知能力,对遥感图像中每个像素根据特征的异同,如光谱亮度、空间结构特征等,按照某种流程或规则对属性进行自动判别和分类,以实现提取图像中包含地物信息的目标[3]。

在对遥感图像分类早期的研究当中,研究者主要选择手工提取图像特征的方法分类遥感图像,代表性的手工提取方法有HOG(histogram of oriented gradient)、ORB(oriented fast and rotated brief)、SIFT(scale invariant feature transform)[4]等。但是随着图像采集技术的不断发展,遥感图像的获取速度加快、采集图像数量猛增,人工提取出的图像特征本身具有信息量小、有效性低等缺陷,难以满足遥感图像的应用需求[5]。因此,为解决传统的图像分类方法在特征提取分析中存在的速度慢和精度低的问题,机器学习方法被应用到图像特征提取和分析方法中[6]。

近年来,以深度学习为代表的机器学习方法被广泛应用在计算机视觉领域的分类任务中[7]。其中,深度卷积神经网络(convolutional neural network,CNN)使得图像分类效率和准确度具有显著的提高[8]。不同于传统的分类方法,CNN具有局部感知和权值共享的特点。局部感知即CNN每层中的每个神经元只需要从当前层输入图像中提取局部的像素特征,在网络的深层中将这些局部信息合并,从而得到图像的所有特征[9]。2014年,由牛津大学提出的VGGNet[10]在ILSVRC大赛中,取得了当年的最优效果。在此后的ILSVRC大赛中,GoogleNet[11]、ResNet[12]等基于CNN的图像分类框架被提出,不断刷新图像分类的最好效果。近年来,林业科研工作者也将CNN算法用于林业遥感图像的分类任务场景中,如地物分类、森林烟火识别等[13-14]。

虽然基于CNN的算法框架在遥感图像分类任务中效果显著,但由于CNN自身具有局部感知特点,导致每个神经元每次计算都只能感知距离中心位置相当近的像素,无法捕捉长距离全局信息,因此对图像分类的准确率无法进一步提高。2014年,Bahdanau等提出注意力(attention)机制[15],该模型旨在解决在机器翻译任务中,传统网络训练时间过长,难以较好实现并行计算的问题。该模型不仅解决了机器翻译中信息瓶颈的问题,同时缓解了循环神经网络(recurrent neural network, RNN)在长距离依赖中梯度消失的问题。受到了注意力机制在自然语言处理领域应用的启发,Dosovitskiy等[16]在2020年的ICLR会议上提出了vision Transformer(ViT)模型,将注意力机制应用于图像分类识别任务中,该模型能有效提取自然图像自身的长距离依赖(图像结构)信息,并能够有效克服CNN中所存在的传导偏差问题。该模型在多个图像识别基准数据集上达到或超越了其他方法,如在ImageNet[17]上达到88.55%的精度。

相较于自然图像,遥感图像具有整体结构复杂,局部纹理性特征丰富等特性。基于CNN的算法虽然能够捕捉局部纹理,但不具备刻画遥感图像全局结构的能力,因此分类准确度会遇到瓶颈。为了同时有效捕捉图像的整体结构和局部纹理信息,本文提出了一种基于自注意力机制和卷积神经网络的融合模型,即,将自注意力模块嵌入到卷积网络模型中,充分发挥两者的优势,在提取遥感图像局部像素特征的同时关注全局结构信息。此外,引入多头变换机制进一步挖掘图像中丰富且差异化的特征纹理信息。本文的方法能够充分考虑到遥感图像的各类特性,对自然图像的识别技术进行了针对性的优化和改进,从而有效地提升了遥感图像分类的精度和效率。具体来说,本算法框架首先将输入图像分成尺寸相同的像素块(patch)输入模型,然后利用深度卷积网络ResNet50作为主干网络提取深度特征,同时将像素块的位置编码信息与深度特征结合,最后将结合的结果通过多头自注意力模块输出到分类器得到分类结果。为了验证本文算法的有效性,使用RSSCN7、Euro SAT和PatternNet等遥感图像地物识别标准数据集进行试验。以期在提高和保证识别精度的情况下,利用更少的模型参数,实现更快的处理速度,便于实际的应用部署。

1. 基于多头自注意力的遥感图像分类算法框架

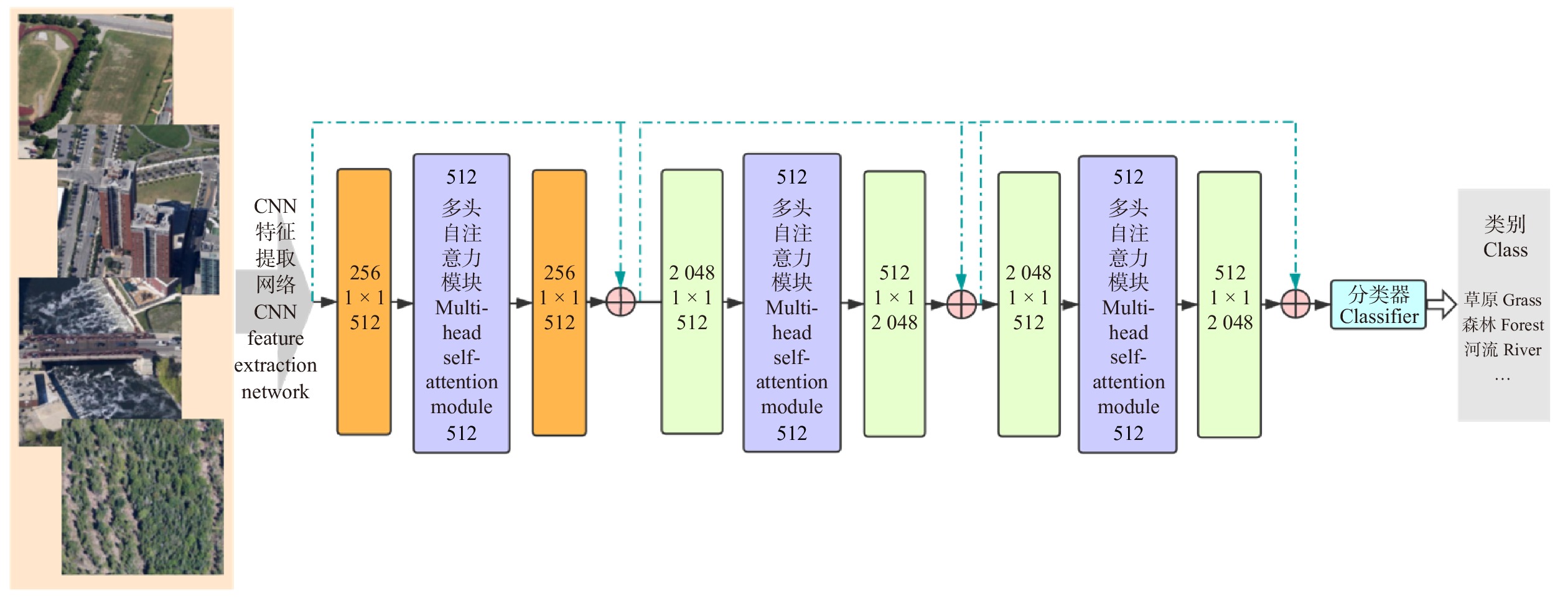

由于基于CNN的算法框架在图像纹理特征提取上具有优越性能,故本算法采用具有残差模块的CNN模型框架ResNet作为主干网络,将前3个卷积网络模块作为特征提取器,在第4个模块中的3个瓶颈层嵌入多头自注意力模块以聚焦全局结构信息。受助于CNN特征提取网络和多头自注意力模块,本框架可以准确感知图像中局部和全局信息,进一步提高遥感图像分类的准确度。本文算法整体结构如图1所示。

1.1 多头自注意力模块

多头自注意力模块由Vaswani等在2017年的NIPS会议上提出,且基于该模块搭建的多头自注意力网络在机器翻译任务上取得了先进的结果并达到了更快的训练速度[18]。故本算法将多头自注意力网络模块应用于遥感图像分类任务,旨在捕捉遥感图像复杂的全局信息。多头自注意力模块主要包括5个关键子模块,分别是位置编码、缩放点积注意力、连接操作、全连接层、归一化连接结构(图2)。

(1)位置编码

位置编码为编码器根据图像特征中的相对与绝对位置信息,通过编码获得的图像特征位置信息。

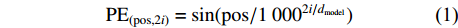

位置编码有正余弦位置编码、学习位置向量和相对位置表达等方式,本研究提出的网络框架采用的是正余弦位置编码方式。在该方式中,编码时使用频率不同的正弦函数与余弦函数,运算过程如公式(1)、(2)所示:

PE(pos,2i)=sin(pos/10002i/dmodel) (1) PE(pos,2i+1)=cos(pos/10002i/dmodel) (2) 式中:pos为特征区域在图像所在位置信息,i为图像特征矩阵的维度,

dmodel 为位置编码器的输出维度。(2)缩放点积注意力

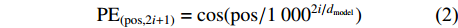

多头自注意力的输入包含查询向量或矩阵Q(query)、键矩阵K(key)、值矩阵V(value)。在计算机视觉领域中,Q、K、V通常是由图像向量构成的矩阵。Q、K、V首先进入缩放点积注意力模块进行运算,如公式(3)所示。

{\rm{Attention}}\left(\boldsymbol{Q},\boldsymbol{K},\boldsymbol{V}\right)={\rm{Softmax}}\left(\frac{\boldsymbol{Q} \cdot {\boldsymbol{K}}^{{\rm{T}}}}{\sqrt{{d}_{k}}}\right) \cdot \boldsymbol{V} (3) 式中:Attention函数为缩放点积注意力操作。而Softmax函数本质上根据Q计算K中每个键的权重,dk是K中每个键的向量维度,分母中的

\sqrt{{d}_{k}} 主要对权重进行缩放,防止向量维度太高时计算出的点积结果过大。计算得到键的权重向量或矩阵后,与值矩阵相乘得到每个键的最终得分。(3)连接操作

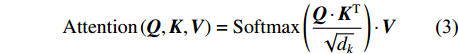

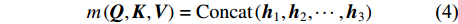

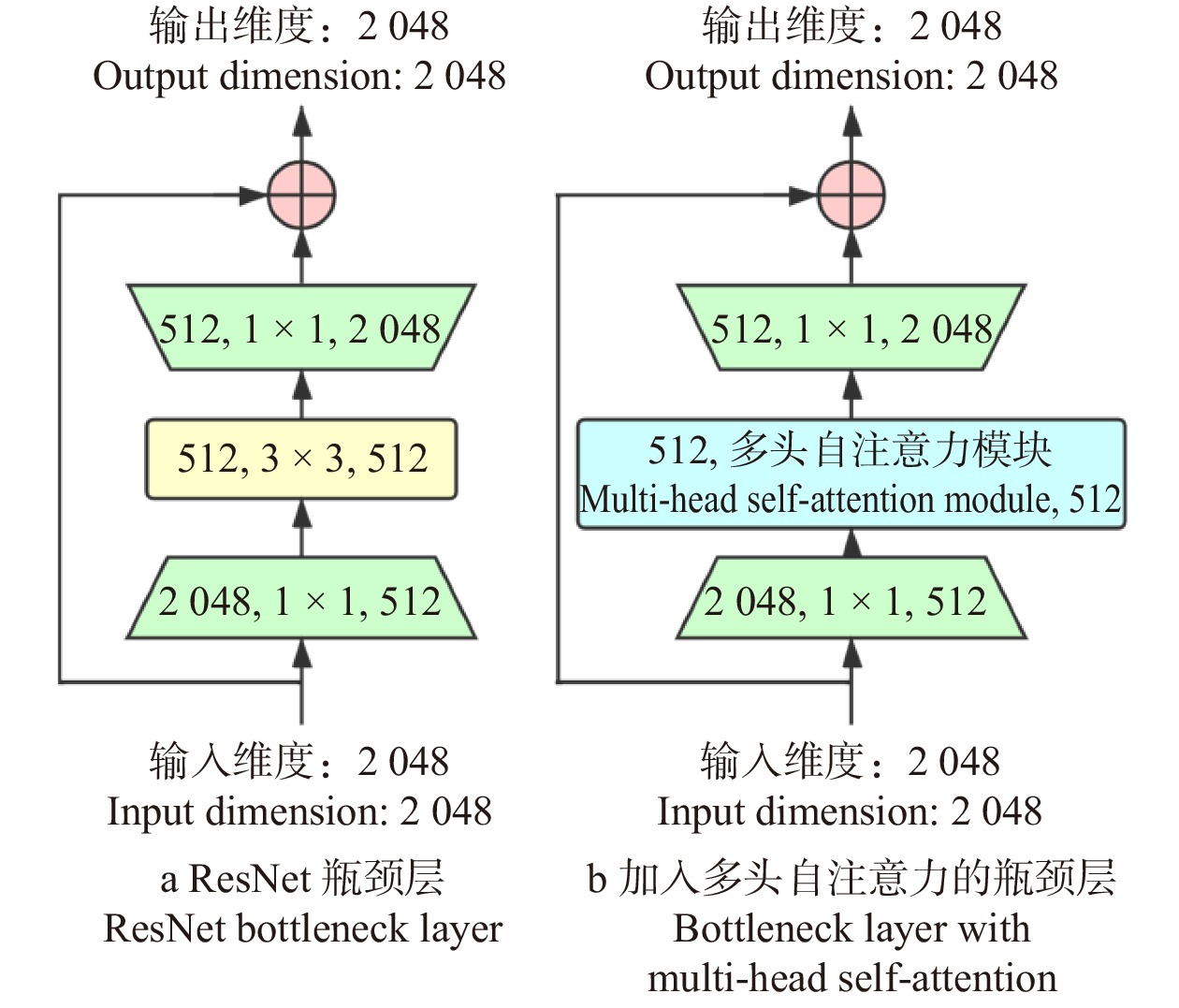

为了增强网络模型捕捉不同结构特征信息的能力,通常会设置多个缩放点积注意力模块,称为多头(multi-head),用m表示,本试验将其值设置为4。其中,每个缩放点积注意力模块计算所得结果称为一个头(head),用h表示。因此,在多头注意力模块需要加入连接操作,整合每个缩放点积注意力模块运算结果。连接操作如公式(4)和(5)所示:

{m}\left(\boldsymbol{Q},\boldsymbol{K},\boldsymbol{V}\right) = {\rm{Concat}}\left({\boldsymbol{h}}_{1},{\boldsymbol{h}}_{2}, \cdots ,{\boldsymbol{h}}_{3}\right) (4) {\boldsymbol{h}}_{1}={\rm{Attention}}\left(\boldsymbol{Q} \cdot {\boldsymbol{W}}_{t}^{Q},\boldsymbol{K} \cdot {\boldsymbol{W}}_{t}^{K},\boldsymbol{V} \cdot {\boldsymbol{W}}_{t}^{V}\right) (5) 式中:t为多头的索引,

{\boldsymbol{W}}_{t}^{\boldsymbol{Q}}{\text{、}}{\boldsymbol{W}}_{t}^{\boldsymbol{K}}{\text{、}}{\boldsymbol{W}}_{t}^{\boldsymbol{V}} 分别为Q、K、V在线性映射运算时对应的参数矩阵,Concat函数表示连接操作。(4)全连接层

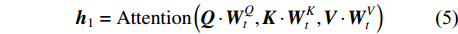

将连接操作后得到的结果输入一个全连接层,进行线性映射操作。计算方式如公式(6)所示。

L\left({{x}}'\right)=\boldsymbol{W}{x}'+b (6) 式中:

{{x}}' 为全连接层的输入,W为权重矩阵参数,b为偏差参数。(5)归一化及残差连接

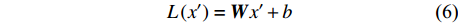

将整个多头注意力模块计算后得到的结果,进行归一化运算,并增加残差模块,以解决深度神经网络的退化问题。

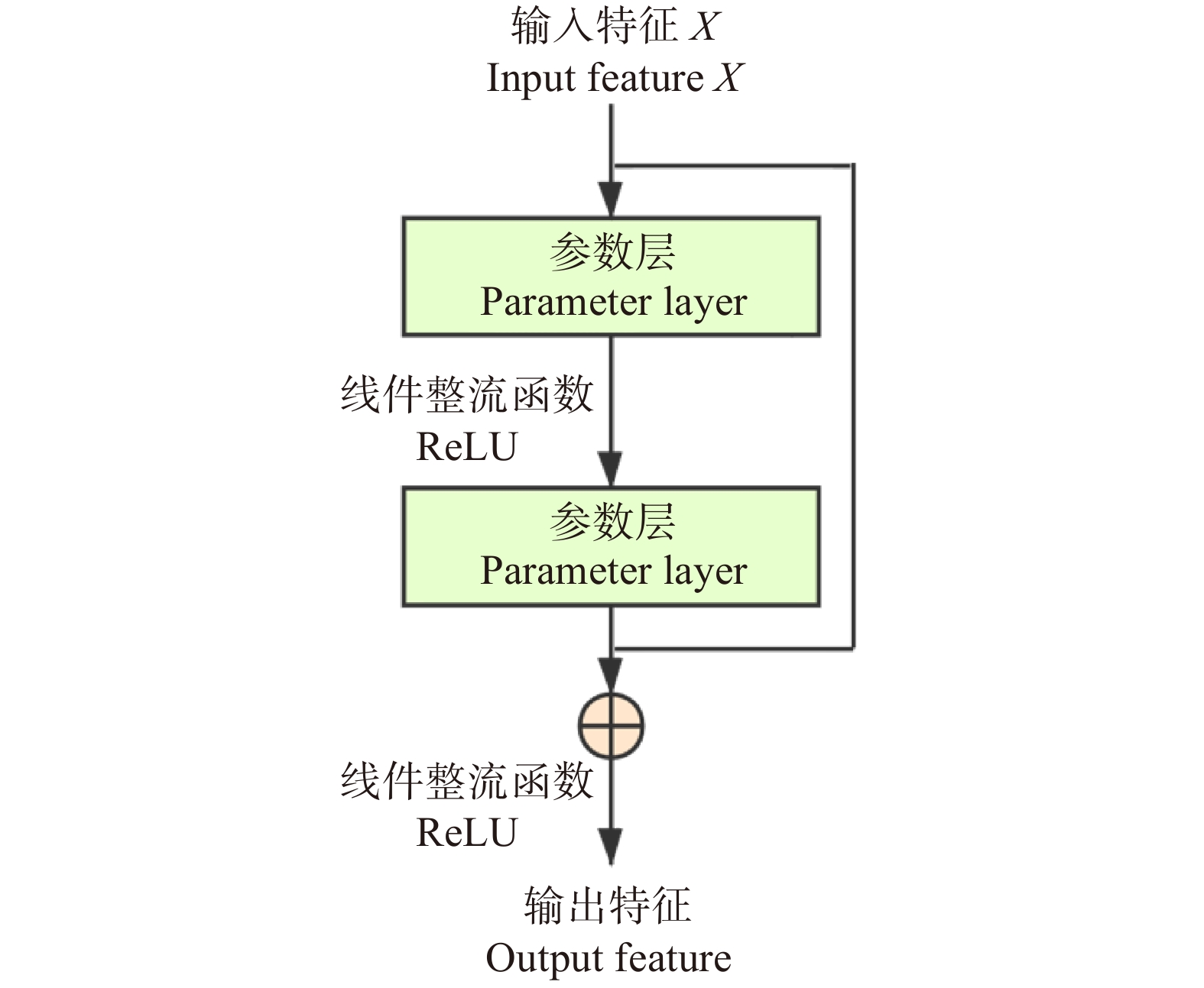

1.2 基于多头注意力的深度残差网络框架

本算法将多头自注意力模块嵌入残差CNN的瓶颈层。框架结构配置见表1,前3个模块与Resnet相同,由残差模块堆叠而成(残差模块示意见图3),区别在于第4模块中所有瓶颈层的中间层由多头自注意力模块替代(见图4)。在试验中,参数初始化采用正态随机生成的方式,旨在使算法对训练所使用的数据集更加敏感,提高算法的分类精度。最后全连接层输出张量大小会根据试验采用的数据集场景类别数量的变化而改变(RSSCN7为7,EuroSAT为10,PatternNet为38)。

表 1 基于多头自注意力模块遥感图像分类框架的结构配置Table 1. Parameter configuration of the proposed framework on multi-head self-attention block模块

Block名称

Name核大小与数量

Kernel size & quantiy步长

Stride重复次数

Repeat time1 卷积

Convolutional7 × 7 × 64 2 1 2 最大池化

Max. pooling3 × 3 2 1 卷积

Convolutional1 × 1 × 64 1 1 3 卷积

Convolutional3 × 3 × 64 2 3 卷积

Convolutional1 × 1 × 256 1 3 4 卷积

Convolutional1 × 1 × 512 1 3 多头自注意力模块

Multi-head self-attention block3 卷积 Convolutional 1 × 1 × 2 048 1 3 平均池化、全连接层、softmax

Average pooling, fully connected layer, softmax注:多头自注意力模块的信息参考图2。Note: The information of multi-head self-attention block refer to Fig. 2. 在训练网络过程中,本研究采用的是交叉熵损失函数(cross entropy loss function)计算该网络在输入的数据集上的损失值(loss),用l表示,其定义式为:

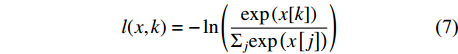

l(x,k)=-\ln\left(\frac{\mathrm{e}\mathrm{x}\mathrm{p}\left(x[k]\right)}{{\Sigma }_{j}\mathrm{exp}\left(x\left[j\right]\right)}\right) (7) 式中:变量x为分类框架中根据输入数据输出的类别预测概率,x是张量,x[j]指的是x的第j维,即输入图像预测为第j类的概率;变量k为输入图像的实际类别。

2. 试验分析

2.1 试验数据

本研究中,将3种目前在遥感图像研究领域广泛使用的数据集作为试验数据,分别为RSSCN7、EuroSAT和PatternNet,已有众多研究工作证明了这些数据集的可用性和有效性[18]。其中,RSSCN7数据集中收集了2 800张遥感图像,包括了遥感图像中的7种场景类别,每一种场景类别共有400张遥感图像,每张图像尺寸大小为400 × 400。这些场景包括草原、森林、工厂、停车场、河流湖泊等。RSSCN7数据集包含的部分遥感图像数据见图5。EuroSAT数据集收集了30 000张遥感图像,包括了遥感图像中10种场景类别,每一种场景类别共有3000张遥感图像,每张图像尺寸大小为64 × 64。EuroSAT数据集包含的部分遥感图像数据见图6。PatternNet包含38个不同类别,每类800张,每张图像的分辨率为256 × 256,共计30 400张。Pattern-Net数据集包含的部分遥感图像数据见图7。

鉴于3个数据集中图像场景类别数目不相等(RSSCN7为7种,EuroSAT为10种,PatternNet为38种),因此,在网络参数训练和精度测试阶段,3个数据集分别单独用于网络的参数训练和精度测试。对于每个数据集,随机抽取70%的数据用于训练,30%的数据用于验证网络分类精度。

在对比试验中,本研究选取了AlexNet[17]、VGGNet、ResNet、ViT等卷积神经网络框架,且有众多研究表明这些卷积神经网络的可行性和有效性。由于部分神经网络对输入图像尺寸具有一定的限制,同时,为了加速试验训练与测试速度,本研究采用图片采样的方式进行数据预处理。通过图像预处理后,RSSCN7和PatternNet数据集图像分辨率为200 × 200,EuroSAT数据集图像分辨率为64 × 64。

本研究所提出的框架在试验过程中主要可分为3个步骤:(1)加载训练好的参数,使用试验采用的数据集的验证数据测试分类效果;(2)修改批次数量大小,对比不同大小对分类效果的影响;(3)测试分类框架的分类速度和参数数量。

2.2 试验环境与参数设置

本研究的所有试验基于PyTorch深度学习框架。程序在Google Colab平台上搭建,使用NVIDIA Tesla P100图形处理器对图像处理流程进行加速。试验中模型优化使用随机梯度下降优化器,其中动量设置为0.9,采用自适应学习速率优化方法,学习率初始值为0.01。最终试验结果选取迭代次数(epoch)为200的模型进行测试。

2.3 试验分析

分类准确度评估。本算法使用RSSCN7、EuroSAT、PatternNet 3个数据集,分别将3个数据集预处理后按照7∶3的比例划分出训练集与验证集。先使用训练集对算法进行参数训练,再使用验证集测试算法的分类效果。为了进一步验证本研究所提出框架的分类有效性与优越性,故增加与现有经典卷积网络以及仅使用多头注意力机制的算法的对比试验。其中,使用的主流卷积网络框架包括AlexNet、VGGNet、ResNet,仅使用多头自注意力模块的网络为ViT。

分类准确度结果见表2,由表可知,本文算法相比目前已有的几种分类框架,在RSSCN7和EuroSAT数据集上得到了最高的分类精度(91.310%,97.877%)。且本研究提出的算法相较于基于ResNet50主干网络的算法,分类准确度也有了明显的提高。在PatternNet数据集上,本文算法分类精度与ResNet50分类准确度接近,但对比ViT分类模型,该框架分类准确度较低。由表2可知,本文算法通过结合卷积神经网络和自注意力机制,能够有效捕捉遥感图像的局部纹理特征和全局结构信息,实现更好的分类精度。本文算法在PatternNet上分类精度不如ViT的原因,可能是PatternNet的样本多含有规则形状的目标,采用分块思想的ViT更能刻画这类信息。

表 2 不同数据集在不同分类算法精度的比较结果Table 2. Comparison of accuracy of different datasets in varied classification frameworks分类框架

Classification framewor分类精度 Classification accuracy/% RSSCN7 EuroSAT PatternNet AlexNet 82.230 91.062 93.697 VGGNet 80.833 90.728 94.118 ResNet50 89.048 94.148 97.697 ViT 89.643 96.111 98.180 使用单头自注意力

Using single-head

self-attention88.143 95.148 97.336 本研究方法

Method used in this study91.310 97.877 97.371 使用消融试验(ablation study)来验证在卷积网络模型中,分别使用自注意力模块和多头自注意力模块替换瓶颈模块是否有助于提升分类准确度。该工作具体做法为用单头自注意力模块和多头自注意力模块分别替换残差卷积网络的瓶颈模块,直接测试对比不同数据集分类准确度。分类准确度见表2。由图可知,相比于未使用自注意力模块的Resnet纯卷积网络消融试验(89.048%、94.148%和97.697%)和采用单头自注意力模块的消融试验(88.143%、95.148%和97.336%),使用多头自注意力模块的本文算法能够得到更高的分类准确度(91.310%、97.877%和97.371%)。

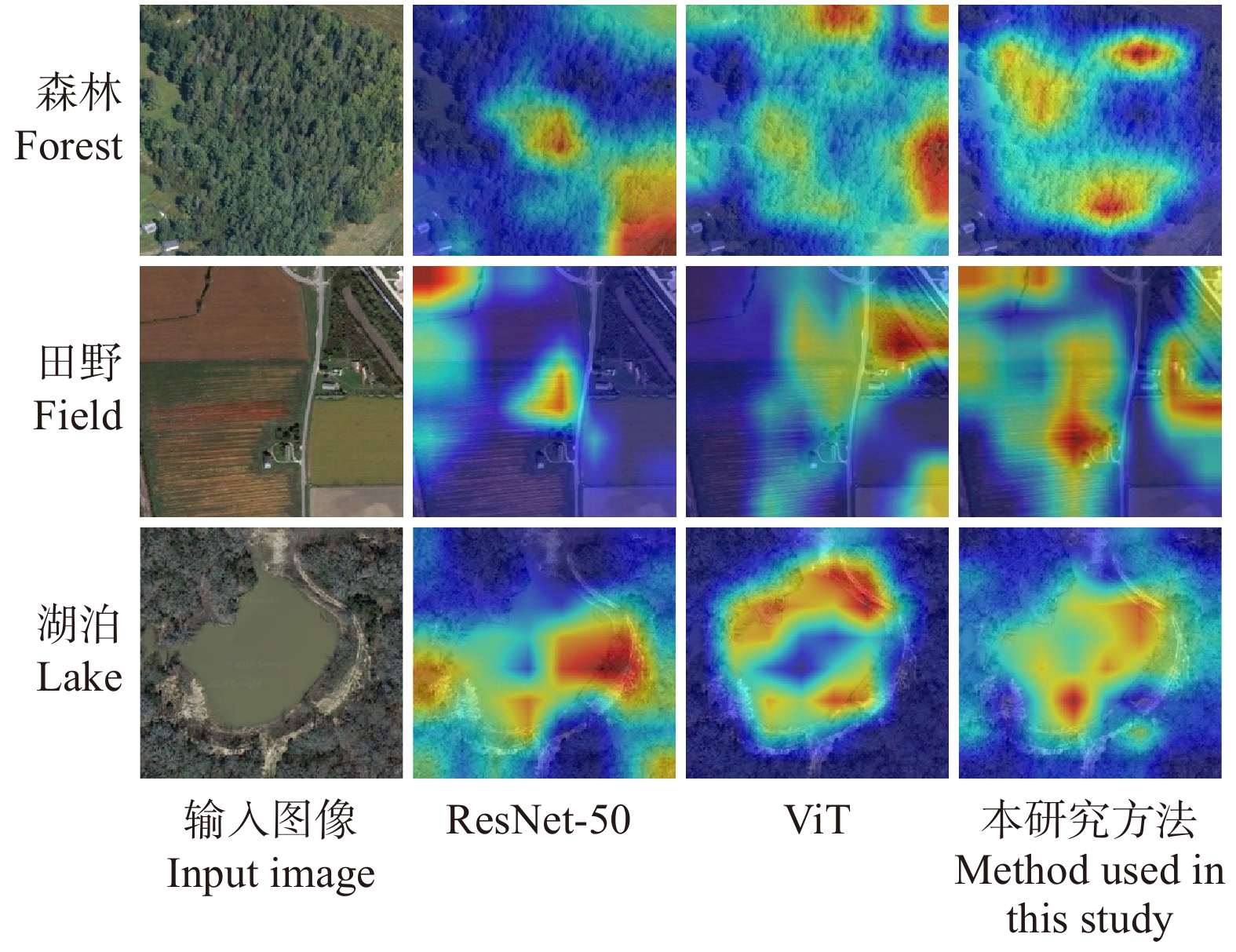

同时,在测试网络效果后,为清晰地对比本文算法框架的效果,对部分分类框架最后1个阶段之后的图像特征对应的加权梯度类激活映射(Grad-CAM)[19]进行可视化。如图8所示,图像中区域的明亮程度代表该区域在分类中所占权重的大小。因此,图8显示出,本文算法能够更加准确地感知到在图像中最具有辨别力的区域,使得分类精度更加准确。

不同训练批次大小测试。在上述精度测试中,每批次输入样本数量(batch size)均为32。为了验证该数值是否可以在训练网络框架时取得最优效果,增加了每批次输入样本数量对提出算法分类效果影响的试验。其中,选取的批次数量大小分别为8、16、32和64,数据集与分类精度测试试验中数据集相同。本文算法在使用不同批次大小分类效果见表3。其中,训练集精度为分类算法用于训练数据集上的正确率,验证集精度则是在算法用于测试数据集上的正确率。

表 3 本研究算法在不同训练批次大小的分类效果Table 3. Classification performance of the proposed framework in different training batch sizes分类框架

Classification

framework样本数量

Batch size分类精度 Classification accuracy/% 训练集 Training set 验证集 Validation set EuroSAT 8 95.162 95.453 16 96.521 96.851 32 97.603 97.877 64 96.143 96.001 RSSCN7 8 90.926 90.532 16 91.237 91.011 32 91.538 91.310 64 91.859 91.137 PatternNet 8 95.947 95.859 16 96.740 96.572 32 98.392 97.371 64 98.593 97.286 由表3中结果可知,当批次数量大小为32时,在各个数据集上分类效果均最优。在训练过程中,当批次数量大小过小时,训练所用时间会变长,且存在严重的梯度震荡,不利于参数的收敛。而参数过大时,参数的梯度方向几乎不会变化,容易陷入局部最优的结果。

算法速度和参数量测试。试验中,算法速度测试分为训练速度测试与分类速度测试两部分。训练速度即使用训练数据集训练模型时参数拟合的速度,本文算法在训练过程中,正确率与损失值随迭代次数变化曲线见图9。由图9可知本算法在PatternNet数据集上收敛速度较快,在EuroSAT数据集上收敛速度较慢。

最后进行本算法运行速度测试,在基于GPU加速的试验环境中,测试了30 400张图像,一共用时345.45 s,平均每秒钟分类88张图像。达到了对遥感图像进行实时分类的标准(高于60帧/s),满足了实际应用中的速度需求。

对算法网络框架各层参数量计算并相加可以求得网络框架中总的参数量。各个分类框架包含的参数数量见表4。其中,本研究提出的分类框架包含了2.08 × 107个参数,ResNet50框架中包含了2.55 × 107个参数。在以ResNet50为主干网络,使用多头自注意力模块替换其中部分结构后,参数量有了明显的降低,减少了显存的开销和运行时的计算量。

表 4 不同分类算法框架包含的参数数量Table 4. Number of parameters contained in different classification frameworks分类框架 Classification framework 参数量 Parameter number AlexNet 6.00 × 107 VGG16 1.33 × 108 ResNet50 2.55 × 107 ViT 2.60 × 107 本研究方法 Method used in this study 2.08 × 107 3. 结 论

本研究提出了一种基于改进自注意力模块的遥感图像分类算法。该算法首先使用ResNet50搭建主干网络进行特征提取,然后将ResNet50瓶颈层的中间层替换为多头自注意力模块。试验中采用RSSCN7、EuroSAT、PatternNet等3个公开数据集进行试验,根据试验结果得出以下结论:

(1)本研究算法在3个数据集上平均识别准确率分别达到了91.310%、97.877%和97.371%,优于目前已有的分类框架,体现了本算法的有效性与优越性。

(2)本研究算法的参数量为2.08 × 107,在分类速度上达到了平均每秒分类88张图像,体现了本算法的高效性。

-

表 1 基于多头自注意力模块遥感图像分类框架的结构配置

Table 1 Parameter configuration of the proposed framework on multi-head self-attention block

模块

Block名称

Name核大小与数量

Kernel size & quantiy步长

Stride重复次数

Repeat time1 卷积

Convolutional7 × 7 × 64 2 1 2 最大池化

Max. pooling3 × 3 2 1 卷积

Convolutional1 × 1 × 64 1 1 3 卷积

Convolutional3 × 3 × 64 2 3 卷积

Convolutional1 × 1 × 256 1 3 4 卷积

Convolutional1 × 1 × 512 1 3 多头自注意力模块

Multi-head self-attention block3 卷积 Convolutional 1 × 1 × 2 048 1 3 平均池化、全连接层、softmax

Average pooling, fully connected layer, softmax注:多头自注意力模块的信息参考图2。Note: The information of multi-head self-attention block refer to Fig. 2. 表 2 不同数据集在不同分类算法精度的比较结果

Table 2 Comparison of accuracy of different datasets in varied classification frameworks

分类框架

Classification framewor分类精度 Classification accuracy/% RSSCN7 EuroSAT PatternNet AlexNet 82.230 91.062 93.697 VGGNet 80.833 90.728 94.118 ResNet50 89.048 94.148 97.697 ViT 89.643 96.111 98.180 使用单头自注意力

Using single-head

self-attention88.143 95.148 97.336 本研究方法

Method used in this study91.310 97.877 97.371 表 3 本研究算法在不同训练批次大小的分类效果

Table 3 Classification performance of the proposed framework in different training batch sizes

分类框架

Classification

framework样本数量

Batch size分类精度 Classification accuracy/% 训练集 Training set 验证集 Validation set EuroSAT 8 95.162 95.453 16 96.521 96.851 32 97.603 97.877 64 96.143 96.001 RSSCN7 8 90.926 90.532 16 91.237 91.011 32 91.538 91.310 64 91.859 91.137 PatternNet 8 95.947 95.859 16 96.740 96.572 32 98.392 97.371 64 98.593 97.286 表 4 不同分类算法框架包含的参数数量

Table 4 Number of parameters contained in different classification frameworks

分类框架 Classification framework 参数量 Parameter number AlexNet 6.00 × 107 VGG16 1.33 × 108 ResNet50 2.55 × 107 ViT 2.60 × 107 本研究方法 Method used in this study 2.08 × 107 -

[1] 王海晖. 不同遥感图像的融合与应用[D]. 武汉: 华中科技大学, 2003. Wang H H. Fusion and application of different remote sensing images[D]. Wuhan: Huazhong University of Science and Technology, 2003.

[2] 曾如珠. 遥感图像分类识别探究[J]. 泉州师范学院学报, 2000, 18(4):1−4. doi: 10.3969/j.issn.1009-8224.2000.04.011 Zeng R Z. On identification of classification of remote sensing images[J]. Journal of Quanzhou Nor-Mal College, 2000, 18(4): 1−4. doi: 10.3969/j.issn.1009-8224.2000.04.011

[3] 李石华, 王金亮, 毕艳. 遥感图像分类方法研究综述[J]. 国土资源遥感, 2005, 64(2):1−6. doi: 10.3969/j.issn.1001-070X.2005.02.001 Li S H, Wang J L, Bi Y. A review of methods for classification of remote sensing images[J]. Remote Sensing for Land & Resources, 2005, 64(2): 1−6. doi: 10.3969/j.issn.1001-070X.2005.02.001

[4] 张裕, 杨海涛, 袁春慧. 遥感图像分类方法综述[J]. 兵器装备工程学报, 2018, 39(8):108−112. doi: 10.11809/bqzbgcxb2018.08.023 Zhang Y, Yang H T, Yuan C H. A survey of remote sensing image classification methods[J]. Journal of Ordnance Equipment Engineering, 2018, 39(8): 108−112. doi: 10.11809/bqzbgcxb2018.08.023

[5] 罗军, 潘瑜春, 王纪华. 基于高分辨率遥感影像的设施农业资源信息采集技术研究[J]. 地理与地理信息科学, 2007, 23(3):51−54. doi: 10.3969/j.issn.1672-0504.2007.03.012 Luo J, Pan Y C, Wang J H. Study on building agricultural resource information collection technology based on high-resolution remote sensing image[J]. Geography and Geo-Information Science, 2007, 23(3): 51−54. doi: 10.3969/j.issn.1672-0504.2007.03.012

[6] 刘建闽, 黄帆, 戴军. 基于机器学习的遥感图像识别检测技术研究及应用[J]. 西安文理学院学报(自然科学版), 2015, 18(4):66−69. doi: 10.3969/j.issn.1008-5564.2015.04.016 Liu J M, Huang F, Dai J. Study and application of the technology of remote sensing image recognition and detection based on machine learning[J]. Journal of Xi’an University of Arts and Science (Natural Science Edition), 2015, 18(4): 66−69. doi: 10.3969/j.issn.1008-5564.2015.04.016

[7] 李国和, 乔英汉, 吴卫江, 等. 深度学习及其在计算机视觉领域中的应用[J]. 计算机应用研究, 2019, 36(12):3521−3529, 3564. doi: 10.19734/j.issn.1001-3695.2018.08.0604 Li G H, Qiao Y H, Wu W J, et al. Review of deep learning and its application in computer vision[J]. Application Research of Computers, 2019, 36(12): 3521−3529, 3564. doi: 10.19734/j.issn.1001-3695.2018.08.0604

[8] 陈超, 齐峰. 卷积神经网络的发展及其在计算机视觉领域中的应用综述[J]. 计算机科学, 2019, 46(3):63−73. doi: 10.11896/j.issn.1002-137X.2019.03.008 Chen C, Qi F. Review on development of convolutional neural network and its application in computer vision[J]. Computer Science, 2019, 46(3): 63−73. doi: 10.11896/j.issn.1002-137X.2019.03.008

[9] 陈波. 基于循环结构的卷积神经网络文本分类方法[J]. 重庆邮电大学学报(自然科学版), 2018, 30(5):705−710. doi: 10.3979/j.issn.1673-825X.2018.05.018 Chen B. Text classification method based on the cycle structured convolutional neural network[J]. Journal of Chongqing University of Posts and Telecommunications (Natural Science Edition), 2018, 30(5): 705−710. doi: 10.3979/j.issn.1673-825X.2018.05.018

[10] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[J/OL]. ArXiv Preprint ArXiv: 1409.1556, 2014[2020−09−04]. https://arxiv.org/abs/1409.1556.

[11] Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston: IEEE, 2015: 1−9.

[12] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016: 770−778.

[13] 张德园, 常云翔, 张利国, 等. SAT-CNN: 基于卷积神经网络的遥感图像分类算法[J]. 小型微型计算机系统, 2018, 39(4):859−864. doi: 10.3969/j.issn.1000-1220.2018.04.042 Zhang D Y, Chang Y X, Zhang L G, et al. SAT-CNN: convolutional neural network framework for remote sensing image classification[J]. Journal of Chinese Computer Systems, 2018, 39(4): 859−864. doi: 10.3969/j.issn.1000-1220.2018.04.042

[14] 徐风, 苗哲, 业巧林. 基于卷积注意力模块的端到端遥感图像分类[J]. 林业工程学报, 2020, 5(4):133−138. doi: 10.13360/j.issn.2096-1359.201907003 Xu F, Miao Z, Ye Q L. End-to-end remote sensing image classification framework based on convolutional block attention module[J]. Journal of Forestry Engineering, 2020, 5(4): 133−138. doi: 10.13360/j.issn.2096-1359.201907003

[15] Bahdanau D, Cho K, Bengio Y. Neural machine translation by jointly learning to align and translate[J/OL]. ArXiv Preprint ArXiv: 1409.0473, 2014[2020−12−01]. https://arxiv.org/abs/1409.0473.

[16] Dosovitskiy A, Beyer L, Kolesnikov A, et al. An image is worth 16x16 words: transformers for image recognition at scale[J/OL]. ArXiv Preprint ArXiv: 2010.11929, 2020[2021−03−01]. https://arxiv.org/abs/2010.11929.

[17] Alex K, Ilya S, Geoffrey E H. ImageNet classification with deep convolutional neural networks[C]// Pereira F, Burges C J C, Bottou L, et al. Proceedings of the 25th International Conference on Neural Information Processing Systems. New York: Curran Associates Inc., 2012: 1097−1105.

[18] Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[C]// Luxburg U V. 31st Annual Conference on Neural Information Processing Systems (NIPS 2017). Long Beach: Curran Associates Inc., 2017: 5998−6008.

[19] Selvaraju R R, Cogswell M, Das A, et al. Grad-CAM: visual explanations from deep networks via gradient-based localization[J]. International Journal of Computer Vision, 2020, 128(2): 336−359. doi: 10.1007/s11263-019-01228-7

-

期刊类型引用(16)

1. 罗豪,李先锋. 基于多尺度特征提取的遥感图像分类. 计算机与现代化. 2025(03): 86-92 .  百度学术

百度学术

2. 张若愚,聂婕,宋宁,郑程予,魏志强. 基于布局化-语义联合表征遥感图文检索方法. 北京航空航天大学学报. 2024(02): 671-683 .  百度学术

百度学术

3. 张名华,张洪军,石建,赵春丽,郑伟安,李天鹤. 基于道路轨迹预测模型的遥感影像分类方法研究. 山东国土资源. 2024(08): 37-41 .  百度学术

百度学术

4. 姚蕊,刘小芳,张杰,郭旭萍. 基于深度学习的FY-4A图像地表太阳辐照度预测. 四川轻化工大学学报(自然科学版). 2024(04): 58-67 .  百度学术

百度学术

5. 刘宝宝,杨菁菁,陶露,王贺应. 基于注意力的DSMSC的遥感图像场景分类. 计算机与现代化. 2024(12): 72-77 .  百度学术

百度学术

6. 陈小勇,郭元术,梁雅博. 基于3D Octave卷积和胶囊网络的高光谱图像分类. 现代电子技术. 2023(05): 29-34 .  百度学术

百度学术

7. 岳泓光,韩龙玫,王正勇,卿粼波. 基于多通道自注意力网络的遥感图像场景分类. 四川大学学报(自然科学版). 2023(02): 97-105 .  百度学术

百度学术

8. 王李祺,高翔,程蓉,谭秀辉,白艳萍. 基于注意卷积模块的遥感图像场景分类应用. 陕西科技大学学报. 2023(02): 199-206 .  百度学术

百度学术

9. 贾浩男,徐华东,王立海,张金生,褚晓辉,唐旭. 基于改进YOLOv5木板材表面缺陷的定量识别. 北京林业大学学报. 2023(04): 147-155 .  本站查看

本站查看

10. 王李祺,张成,侯宇超,谭秀辉,程蓉,高翔,白艳萍. 基于深度学习特征融合的遥感图像场景分类应用. 南京信息工程大学学报(自然科学版). 2023(03): 346-356 .  百度学术

百度学术

11. 何晓军,刘璇,魏宪. 融合字典学习与视觉转换器的高分遥感影像场景分类方法. 激光与光电子学进展. 2023(14): 189-198 .  百度学术

百度学术

12. 李子茂,于舒,郑禄,帖军,秦锦添. 基于融合注意力机制的小样本遥感场景分类方法. 国外电子测量技术. 2023(07): 59-67 .  百度学术

百度学术

13. 李大湘,南艺璇,刘颖. 面向遥感图像场景分类的双知识蒸馏模型. 电子与信息学报. 2023(10): 3558-3567 .  百度学术

百度学术

14. 吴文彦. 基于卷积通道注意力及改进ResNet的遥感场景分类. 兰州工业学院学报. 2023(06): 26-30 .  百度学术

百度学术

15. 丁竹娴,周立军,樊江川,安锋,陈帮乾,王铭慧,蒋玲,薛联凤,云挺. 基于深度学习与激光点云的橡胶林枝干重建及参数反演. 农业工程学报. 2022(08): 187-199 .  百度学术

百度学术

16. 闾海庆,王静,杨静. 半监督高分辨率遥感图像分类方法. 北京测绘. 2022(06): 827-830 .  百度学术

百度学术

其他类型引用(14)

下载:

下载: